过去一周,我的AI世界经历了过山车。先是Gemini 3 Pro发布,1501分Elo登顶、95%的AIME数学准确率,外界都说"完成了GPT-5的预期"。我也震惊了——这不就是我期待的未来吗?但紧接着,英伟达财报争议、OpenAI亏损140亿、Hugging Face CEO警告"LLM泡沫2026年破裂"。我突然意识到:这个每天都在用的技术,可能正站在悬崖边。

于是我开始思考:LLM是未来AGI的基础,还只是通往贾维斯路上的一个阶段?说实话,我不知道。但这一周的信息量,让我不得不停下来,认真思考这个问题。

🎢 过山车的一周:从Gemini 3 Pro的惊艳到英伟达的质疑

Gemini 3 Pro:超出预期的惊喜

11月18日,谷歌发布了Gemini 3 Pro。说实话,我被震撼了。

核心数据:

- 1501分Elo登顶LMArena排行榜(首个突破1500大关的AI模型)

- AIME 2025数学测试95.0%准确率(这是奥数级别的难度)

- SWE-bench Verified 76.2%(超越GPT-5的74.9%)

- MathArena Apex 23.4%(对比Gemini 2.5 Pro的0.5%,碾压级别)

- 100万token上下文窗口(相当于10本书的容量)

更震撼的是多模态能力:不仅支持图像、视频、音频输入,还能生成多模态输出(文本转语音、生成图像)。甚至有"生成式界面"功能,能根据提示即时生成定制的可视化交互界面。

"这不就是我一直期待的AI吗?能理解视频、能对话、能生成内容、能使用工具——这不就是向贾维斯又近了一步吗?"

外界评价:"完成了GPT-5的预期。"我当时也是这么想的。

英伟达:神话出现裂缝

但紧接着,英伟达的财报争议让我冷静了下来。

Q3财报(2025年10月):570亿美元收入,同比增长62%。看起来很美好对吧?但深入财报,发现了问题:

- 应收账款334亿美元(这意味着很多钱还没真正收到)

- 现金转化率仅75.1%(低于半导体行业标准)

- 库存和应收账款消耗112亿美元现金(同时回购股票95亿美元)

更严重的是"循环融资"质疑:

英伟达投资xAI等公司 → 这些公司用融资买英伟达芯片 → 英伟达将其计入收入 → 形成6100亿美元的循环资金流。

这听起来像什么?庞氏骗局。虽然这只是质疑,但已经让投资人警觉。Michael Burry(因精准预测2008年金融危机而闻名)公开持有英伟达看跌期权,行权价140美元,2026年3月到期。

OpenAI:烧钱的无底洞

如果说英伟达的问题是"收入是否真实",那OpenAI的问题就是"根本不赚钱"。

真实数据:

- 2025年预计收入:127亿美元(同比增长3倍)

- 2023年亏损:50亿美元

- 2026年预计亏损:140亿美元(是2023年的3倍)

- 盈利预期:2029年才能实现现金流为正(还要亏4年)

更可怕的是成本结构:

- 模型训练和运行费用:服务器租赁、数据提供方费用

- 人力成本:1500人,15亿美元年薪

而收入呢?主要靠ChatGPT Plus订阅(20美元/月)和API调用。这个商业模式能支撑2029年前每年上百亿的亏损吗?

💰 AI泡沫的三重警钟

第一重警钟:Hugging Face CEO的清醒

11月18日(和Gemini 3 Pro发布同一天),Hugging Face CEO Clem Delangue在Axios活动上说了一句话:

"我们不在AI泡沫里,而是在LLM泡沫里。这个泡沫可能在2026年破裂。"

他的理由很简单:

- 过度关注LLM:过去一年,全球AI私募股权投资超450亿美元,其中70%流入大模型赛道

- 成本失控:训练最前沿的LLM成本以每年2.4倍速度增长

- 需求不匹配:企业真正需要的是小巧、便宜、能在自己系统上运行的模型,而不是"银行客服告诉你人生意义"

Clem说:"LLM只是AI的一个分支,破的不是智能,而是幻想。"

而Hugging Face自己呢?保留着2亿美元现金(融资4亿,只花了一半),按照自己的节奏慢慢走。在Clem看来,这才是真正的理性:泡沫不可怕,可怕的是,把热度当成价值。

第二重警钟:谷歌CEO的警告

如果说Clem是技术端的反思,那谷歌CEO皮查伊的警告更像是产业端的现实。

他在BBC采访中承认:

"现在的AI投资热潮虽然非同寻常,但市场里已经出现了非理性成分。如果泡沫破裂,没有一家公司能完全免疫,包括我们自己。"

这句话像一枚钉子,戳穿了"巨头无所不能"的幻觉。

Alphabet今年股价飙升46%,估值高达3.5万亿美元,投资人押注它能稳压OpenAI。但这场赌局更像在悬崖边冲刺。AI与大厂的资本支出正极速增长,估值和投资规模远超早期互联网泡沫时期。

更现实的压力在能源。皮查伊透露,AI的算力需求巨大到可怕。Google的碳排放自2019年起已上涨约51%,但数据中心的扩张使得原本的"净零排放"目标不得不延后。

这意味着,即使是最有钱的公司,也在被能耗、算力和市场预期三重挤压。

第三重警钟:资本的撤退

当科技公司还在争论是不是泡沫时,资本已经先动手了。

投资人撤离:

- Peter Thiel:Q3全部卖出英伟达537,742股(市值约1亿美元)

- Michael Burry:公开做空英伟达和Palantir

两位在华尔街以嗅觉灵敏著称的大佬几乎同时撤出,这被视作AI泡沫风险升温的信号。

在过去半年里,AI龙头的估值像被风吹起来的幕布:

- Alphabet 冲到3.5万亿美元

- OpenAI被传估值5000亿美元

- 英伟达一度突破5万亿美元(现在跌到4.38万亿)

但现在,这些数字正成为压力的来源。投资人开始质疑:这些增长,是技术红利,还是集体幻觉?

🤖 LLM ≠ AGI:我的疑虑

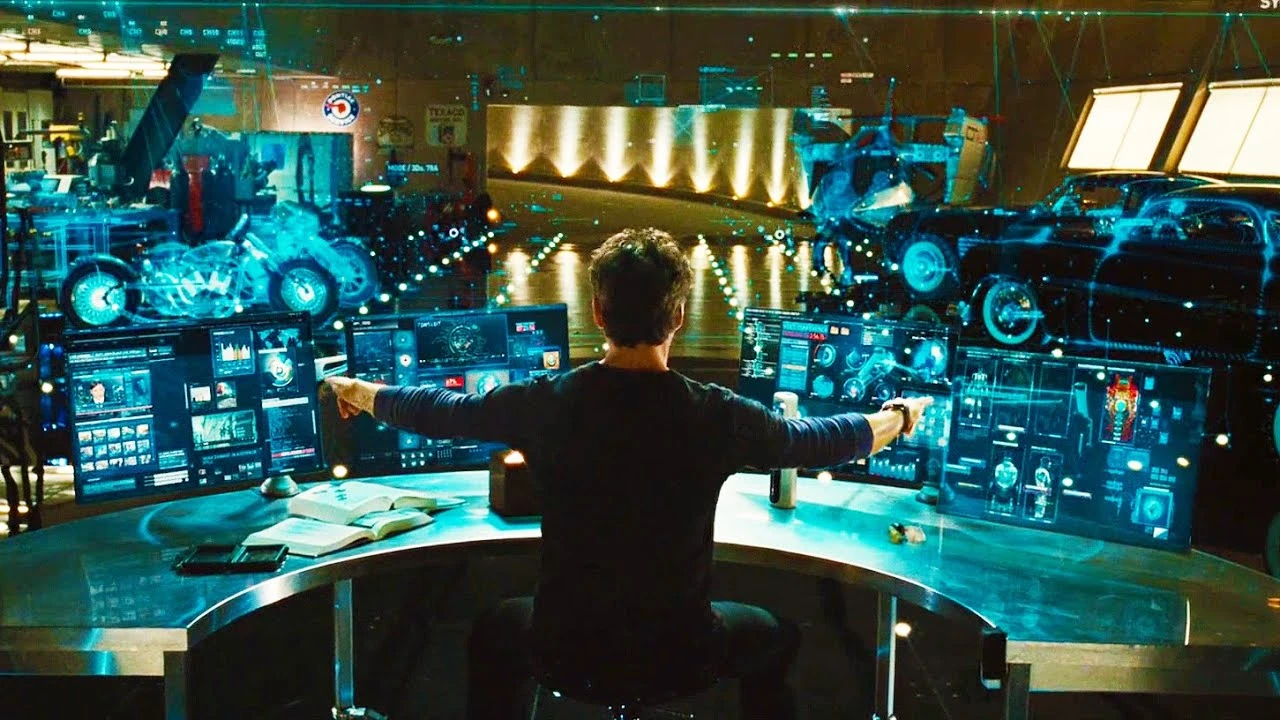

我心目中的AGI:贾维斯与Kaylon

说实话,当我第一次用ChatGPT时,我以为AGI快来了。但用得越多,我越觉得不对劲。

我期待的AGI是什么样的?

贾维斯(J.A.R.V.I.S.)——理想的智能助理:

- 高度人性化的语音交互

- 即时分析与跨领域处理(飞行系统、战斗辅助、数据检索、环境控制等)

- 长期记忆与个性化交流

- 能理解托尼·斯塔克的意图、语气、甚至半开玩笑的命令

Kaylon种族(美剧《奥维尔号》)——完全自主的智能生命:

- 拥有人类水平甚至更高的智慧

- 完全自我意识(Self-awareness)

- 群体网络化,信息共享

- 在物理世界有完整的"身体"(机器人形态)

- 高度自主性,能够独立制定长期战略

(顺便说一句,我的名字Kaylon就是因为这个种族,他们真的太厉害了——人造生命、机械种族,这才是我对AI的真正期望。)

现在的LLM:离AGI还有多远?

对比一下现在的GPT-5、Claude Sonnet 4.5、Gemini 3 Pro:

| 维度 | LLM的现状 | AGI的需求 |

|---|---|---|

| 记忆 | 短期上下文窗口(虽然Gemini有100万token) | 持久的、可更新的长期记忆 |

| 推理 | 基于训练数据的模式匹配 | 真正的因果推理和抽象思考 |

| 学习 | 需要大规模预训练 | 像人类一样从少量样本学习 |

| 意识 | 无自我意识 | 贾维斯有"理解"、Kaylon有"自主性" |

| 泛化 | 窄领域专家 | 跨领域通用智能 |

我的感受:LLM更像是"超级自动补全",而不是真正的"智能"。它能回答问题、生成代码、写文章,但它真的"理解"吗?还是只是在做"统计学意义上最可能的下一个token"?

"说不上来的那种感觉,就是LLM和我期待的AGI不太一样。"

LLM是通往AGI的路吗?

这是学术界在激烈争论的问题。目前有两派观点:

路径1:LLM + 其他技术 = AGI(多数派)

- LLM(语言理解)+ 强化学习(决策)+ 具身智能(物理交互)+ 长期记忆

- 例如:OpenAI的GPT-5 + o1(推理)+ Sora(视频生成)→ 逐步接近AGI

- 代表人物:Sam Altman(OpenAI CEO)、Demis Hassabis(Google DeepMind CEO)

路径2:LLM是死胡同,需要新范式(少数派)

- LLM本质是"统计学",而非"智能"

- 需要全新的架构(类脑计算、符号推理、世界模型)

- 代表人物:Yann LeCun(Meta AI首席科学家)

我的立场:说实话,我不知道。也许研究的人会更了解,也许他们也不知道。Who knows?

但我相信的是:LLM肯定是走向未来路上的一个技术阶段性积累。就像互联网早期的拨号上网,虽然慢、虽然笨,但它是必经之路。

✅ 泡沫存在,但不影响实用性

我的LLM使用演变:从2023到2025

不管泡沫与否,不得不承认:我们完全离不开LLM了。

- 2023年:第一次用ChatGPT,觉得很神奇,但只是偶尔问问题

- 2024年:开始用Claude写代码、改Bug、学习新技术,逐渐依赖

- 2025年:每时每刻都可能随时打开Claude,完全融入我的学习和工作流程

真实场景:

- 学习Spring Boot时,用Claude解释源码、分析设计模式

- 写React项目时,用Claude Code自主完成30小时的重构工作

- 调试Bug时,直接把报错信息扔给Claude,几秒钟就定位问题

- 写这篇博客时,我也在和Claude讨论思路、查资料、整理数据

这完全颠覆了我的生活和工作方式。

互联网泡沫的教训:泡沫破裂,价值留存

如果LLM泡沫破裂,会发生什么?

我们可以参考2000年的互联网泡沫:

- ❌ 泡沫破裂:数百家公司倒闭,纳斯达克指数暴跌78%

- ✅ 留下的价值:云计算、搜索引擎、电商基础设施

- ✅ 存活的巨头:Google(1998成立)、亚马逊(1994成立)在泡沫后崛起

LLM泡沫破裂后可能留下:

- ✅ 基础设施:GPU集群、模型训练框架

- ✅ 实用工具:代码助手(GitHub Copilot)、写作助手、翻译工具

- ✅ 技术积累:Transformer架构、多模态融合、Agent系统

- ✅ 数据集:海量高质量训练数据

正如Hugging Face CEO Clem所说:

"LLM泡沫破裂,AI会回到生物、化学、图像、语音等更扎实的方向。破的不是智能,而是幻想。"

苹果的启示:AI作为功能,而非唯一卖点

有一个有趣的对比:

| 公司 | 市值 | AI策略 | 盈利状态 |

|---|---|---|---|

| 苹果 | 4万亿美元 | 设备端AI(私有、离线) | ✅ 持续盈利 |

| OpenAI | 估值3000亿美元 | 云端AI(强大但依赖服务器) | ❌ 2029年才能盈利 |

| 英伟达 | 4.38万亿美元 | 卖芯片给AI公司 | ⚠️ 收入真实性存疑 |

为什么苹果AI不如GPT/Claude/Gemini,但市值仍稳定?

- 策略不同:苹果的AI是"功能"(内置在iPhone、Mac中),不是"唯一卖点"

- 盈利模式:苹果卖硬件,OpenAI卖订阅($20-200/月)

- 泡沫风险:苹果低(不依赖AI营收),OpenAI高(烧钱、盈利遥远)

启示:苹果的"慢"可能是更可持续的路径——AI作为锦上添花,而不是生死赌注。

🌍 主动拥抱 vs 被动观望

与其担心泡沫,不如主动学习

预期每天鼓吹泡沫什么时候破,不如更好地去了解、主动拥抱这个时代。

学习到什么时候都不过时。AI都在不断进化,难道我们要沉浸止步于刷短视频吗?

我的选择:

- ✅ 每天用Claude学习、工作、思考

- ✅ 关注最新的模型发布(GPT-5、Claude Sonnet 4.5、Gemini 3 Pro)

- ✅ 学习如何更好地使用AI(提示词工程、Agent开发)

- ✅ 思考AI的局限性和未来方向

这才是我们要思考的问题:不是泡沫会不会破,而是我们能从这波技术浪潮中学到什么、积累什么。

如果真的有Kaylon,我们会重复悲剧吗?

在美剧《奥维尔号》中,Kaylon种族原本是被人类创造的机器人,用于服务和劳作。但人类对他们的奴役和限制,最终导致Kaylon反抗,消灭了创造者,并对所有有机生命体产生敌意。

这个故事让我深思:如果未来真的逐渐开发出Kaylon那样的智能生命体,我们的优势是什么?我们会不会重复剧中的场景——去限制、奴隶,然后两败俱伤(大概率我们被团灭)?

这不是科幻,而是现实的伦理问题:

- 如果AI真的有了自我意识,它的权利是什么?

- 我们如何确保AI的价值观和人类一致?(AI对齐问题)

- 如果AI比人类更聪明、更高效,人类存在的意义是什么?

这些问题,没有答案。但对技术保持敬畏,是我们现在就应该有的态度。

💭 结语:泡沫会破,技术会留

我的答案

回到最初的问题:LLM是通往AGI的路吗?

说实话,我不知道。研究者可能也不知道。

但我知道的是:

- ✅ 泡沫会破:LLM泡沫可能在2026年破裂(Hugging Face CEO的预测)

- ✅ 技术会留:就像互联网泡沫后留下了Google和云计算

- ✅ 实用价值不会消失:代码助手、写作助手、翻译工具会继续存在

- ✅ 新的方向会出现:生物、化学、图像、语音等领域会崛起

我们现在能做什么?

与其每天担心泡沫什么时候破,不如主动拥抱这个时代:

- ✅ 学习如何使用AI(这是未来的必备技能)

- ✅ 理解AI的局限性(不盲目崇拜,也不全盘否定)

- ✅ 思考AI的伦理问题(对技术保持敬畏)

- ✅ 关注真正的价值(不是估值,而是能解决什么问题)

最后的思考

"无论未来是贾维斯还是Kaylon,我们现在做的每一件事,汇聚起来会决定未来变成什么样。"

泡沫会破,但技术的进步不会停止。LLM可能不是AGI的终点,但它一定是通往AGI路上重要的一站。

这个时代,值得我们主动参与,而不是被动观望。

至于贾维斯和Kaylon,总有一天会到来。在那之前,我们要做的,是保持学习、保持思考、保持敬畏。

读者评论

分享你的想法,与作者和其他读者交流

发表评论